1 Ollama PC本地化部署

1.1 下载Ollama

https://ollama.com/

目前Ollama支持macOS、Linux、Windows,选择相应的系统,macOS和Windows直接下载,Linux系统需要执行下面命令:

|

curl -fsSL https://ollama.com/install.sh | sh |

选择Windows本地下载,直接安装即可。

1.2 选择模型

点击Models,第一条就是deepseek-r1模型。或者搜索框输入模型名称进行搜索。

点击进去后,查看各个模型,不同模型执行的命令不同,最后部分看你选择的参数模型。

7b命令:ollama run deepseek-r1:7b

1.5b命令:ollama run deepseek-r1:1.5b

DeepSeek R1提供多个版本,参数量越大,模型通常越强大,但也需要更多的计算资源。

比如1.5B代表有15亿个参数。

具体选择哪一个看你硬件设备了。

1.3 运行命令

选了1.5b。如果你配置高,可以选择更大的,毕竟越大效果越好。

ollama run deepseek-r1:1.5b

1.4 效果测试

当界面出现success显示安装成功。

输入你是谁,看到deepseek的回答。

DeepSeek+Chatbox网页端

本地命令行使用还是不太直观,可以选择Chatbox进行网页端访问,提高可交互性。

Chatbox AI 是一款 AI 客户端应用和智能助手,支持众多先进的 AI 模型和 API,可在 Windows、MacOS、Android、iOS、Linux 和网页版上使用。

本地使用Ollama部署完成后,可以使用Chatbox进行调用。

根据官方文档给出的步骤进行配置

https://chatboxai.app/zh/help-center/connect-chatbox-remote-ollama-service-guide

2.1 环境变量配置

默认情况下,Ollama 服务仅在本地运行,不对外提供服务。

要使 Ollama 服务能够对外提供服务,你需要设置以下两个系统的环境变量:

OLLAMA_HOST:0.0.0.0

OLLAMA_ORIGINS:*

在 Windows 上,Ollama 会继承你的系统环境变量。

1、通过任务栏退出 Ollama。

2、打开设置(Windows 11)或控制面板(Windows 10),并搜索“环境变量”。

3、点击编辑你账户的环境变量。

4、为你的用户账户编辑或创建新的变量 OLLAMA_HOST,值为 0.0.0.0; 为你的用户账户编辑或创建新的变量 OLLAMA_ORIGINS,值为 *。

5、添加 OLLAMA_MODELS 环境变量改变模型存储的位置。例如 E:\ollama\models

- 设置完成后重启

ollama或PowerShell,即可完成更改。

6、从 Windows 开始菜单启动 Ollama 应用程序。

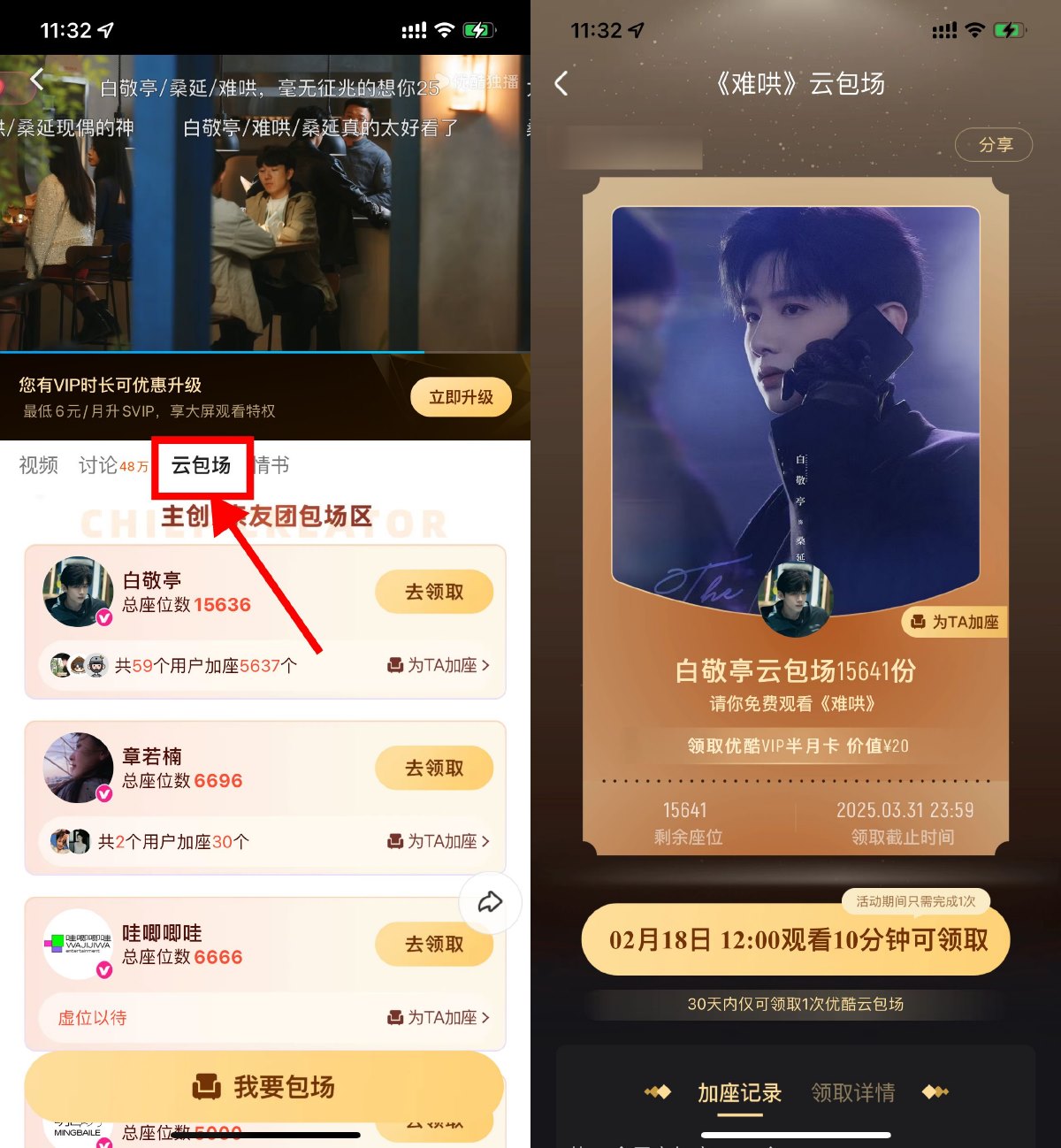

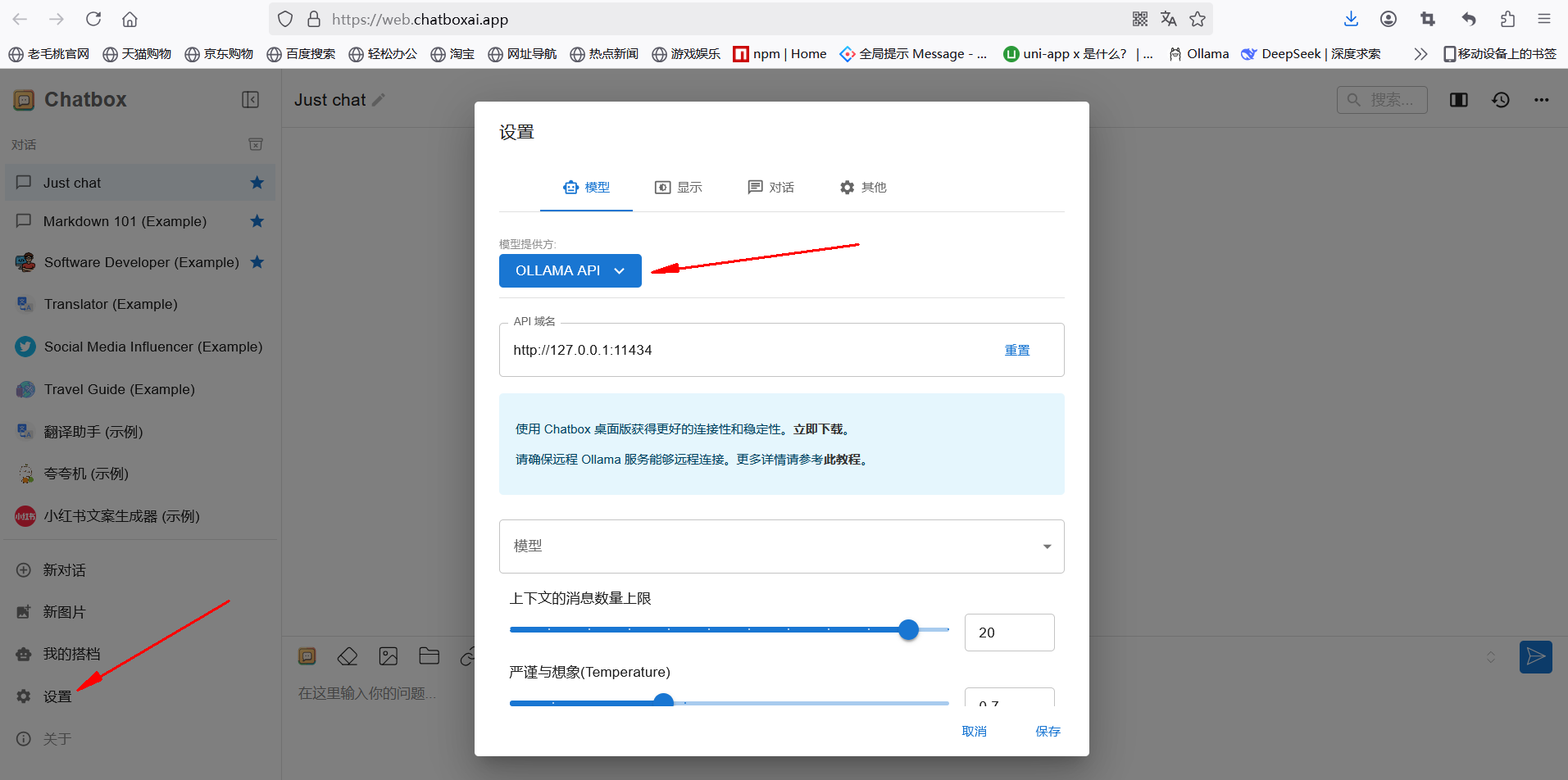

2.2 chatbox设置

1、打开官网:https://chatboxai.app/zh,选择启动网页版。

2、选择本地模型,如果找不到,点击左侧的设置按钮。

3、选择Ollama API。

4、选择模型,本地运行Ollama后会自动出现模型的选项,直接选择即可。

5、语言选择》点击DISPLAY,选择简体中文,点击保存按钮。

6、在聊天窗口输入问题进行测试。

如果还有小伙伴不懂教程的,可联系站长帮忙进行搭建。一次30元。

免责声明

技术导航提供的一切软件、教程和内容信息仅限用于学习和研究目的;不得将上述内容用于商业或者非法用途,否则,一切后果请用户自负。本站信息来自网络收集整理,版权争议与本站无关。您必须在下载后的24个小时之内,从您的电脑或手机中彻底删除上述内容。如果您喜欢该程序和内容,请支持正版,购买注册,得到更好的正版服务。我们非常重视版权问题,如有侵权请邮件1431400334@qq.com与我们联系处理。敬请谅解!